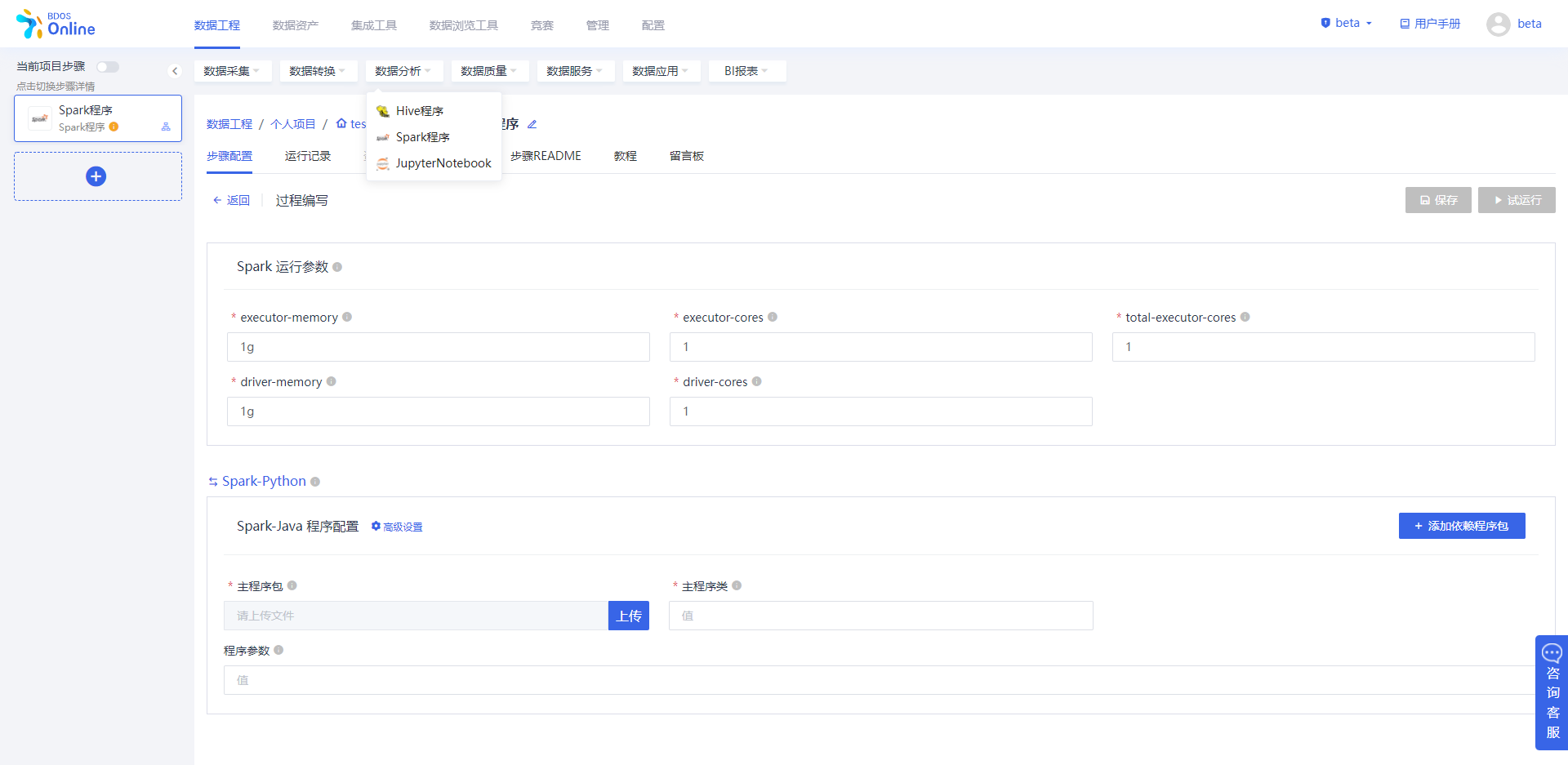

数据工程-Spark程序

用户点击数据处理-Spark程序图标,添加Sprk程序步骤至数据工程步骤列表。点击该步骤编辑,进入Spark程序步骤编辑界面。

步骤配置

用户可在步骤主体界面,进行过程编写配置

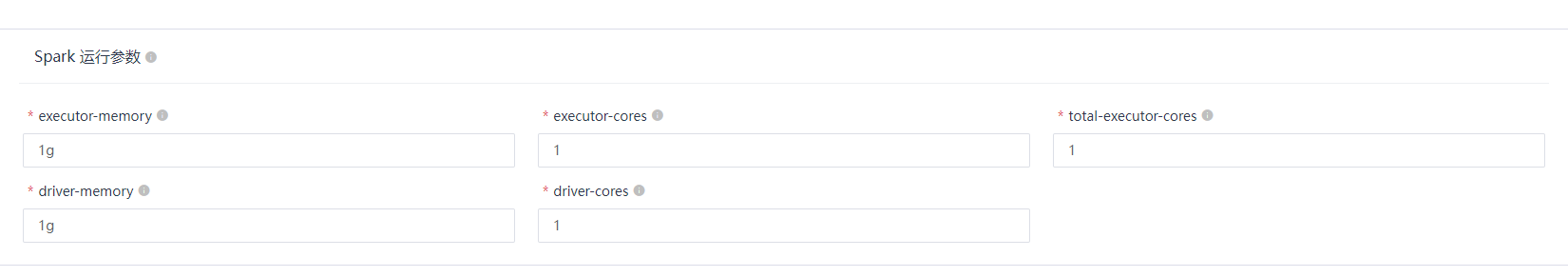

Spark运行参数

| 信息项 | 内容 | 备注 |

|---|---|---|

| executor-memory* | 1g(系统默认) | 执行器的内存,用户自定义 |

| executor-cores* | 1(系统默认) | 执行器内核个数,用户自定义 |

| total-executor-cores* | 1(系统默认) | 执行器的内核个数总和 |

| driver-memory* | 2g(系统默认) | 驱动参数,用户可自定义 |

| dirver-cores | 2(系统默认) | 驱动内核数,用户可自定义 |

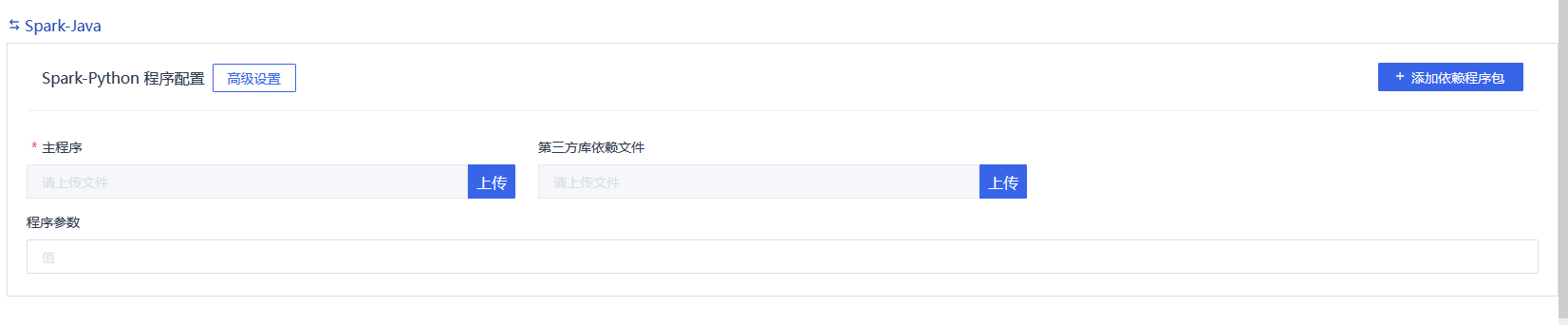

Spark-Python程序配置

编写Python语言,使用Spark计算引擎进行数据清洗和整合,批处理的技术手段,性能上优于Hive。

| 信息项 | 内容 | 备注 |

|---|---|---|

| 主程序* | 点击【上传】程序包 | 将已制作好的程序包上传,支持添加多个 |

| 第三方库依赖文件 | 点击【上传】依赖文件 | 将已制作好的第三方库依赖文件上传,支持添加多个依赖包可支持一个或多个.zip,.egg或 .py文件 |

| 程序参数 | 用户根据程序内容,填写需要调用的程序参数 |

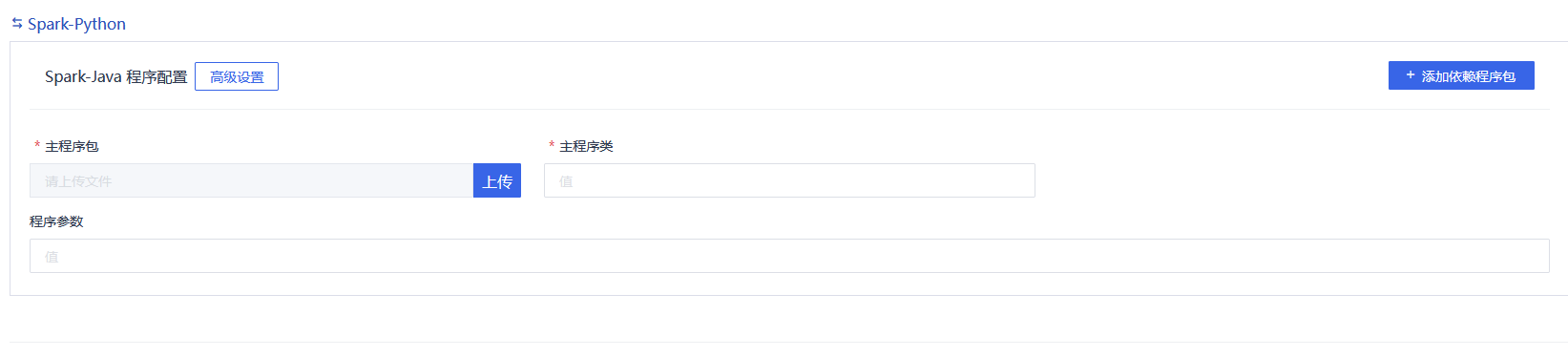

Spark-Java

编写Java语言,使用Spark计算引擎进行数据清洗和整合,批处理的技术手段,性能上优于Hive。

| 信息项 | 内容 | 备注 |

|---|---|---|

| 主程序* | 点击【上传】本地程序包 | 将已制作好的程序包上传 |

| 主程序类* | 用户主程序类的值 | |

| 程序参数 | 用户自定义 |

*高级功能*

| 信息项 | 内容 | 备注 |

|---|---|---|

| 系统变量 | 默认无 | 系统提供year,month,hour,day,minute,second,datetime及timestamps等变量,用户根据需要设置参数。系统时间变量是提供当前调度时间对应某个固定格式的变量,比如year就是调度时间的年份、datetime就是yyyyMMddHHmmss的固定格式。主要作用在于,如果被调度的程序,需要获取调度时间,则可以通过上述变量进行传递。 |

| 用户自定义变量 | 默认无 | 用户根据需要,自行【添加】变量并设置参数值作为系统 |

配置完成后点击保存

点击运行,运行Hive程序步骤,并查看运行日志

上下游数据

用户成功执行该步骤后,可通过上下游数据界面查看上下游数据信息。时间同步有时耗,需等待片刻进行查看。

运行记录

用户可通过界面,查看步骤的历史运行记录日志详情。

留言

评论

暂时还没有一条评论.