号称“全球最快”:比英伟达(NVDA.US)GPU快20倍!Cerebras 推出全球最快 AI 推理解决方案

本文由智领云 LeetTools 工具自动生成

原文链接:

https://svc.leettools.com/#/share/feng/research?id=b6fb16d3-305a-4fc4-b70d-6edab692ec6e

如果您想试用,请点击链接:https://www.leettools.com/feedback/

Cerebras Systems最近推出的Cerebras Inference被誉为全球最快的AI推理解决方案,其性能比NVIDIA的产品快20倍,同时成本却大幅降低。这一创新不仅为开发者提供了前所未有的速度和效率,还在处理复杂的AI任务时保持了高准确性。Cerebras Inference能够每秒处理1,800个Llama 3.1 8B的令牌和450个Llama 3.1 70B的令牌,展现了其卓越的处理能力。

Cerebras的这一新的解决方案利用了Wafer Scale Engine 3(WSE-3)芯片,显著提升了AI工作负载的速度和成本效益。通过提供按需付费的模式,Cerebras希望能够彻底改变推理市场,并通过更快的处理速度提升AI响应的质量。Cerebras还计划将其服务扩展到云端和本地解决方案,标志着其从硬件销售向推理服务转型的重要一步。

Cerebras推理的技术优势

Cerebras推理解决方案在性能、成本效率和底层技术方面相较于传统的人工智能推理解决方案展现出显著的优势。

在性能指标上,Cerebras推理的速度是当前市场上最快的,能够达到每秒处理1,800个令牌的速度,这比基于NVIDIA H100 GPU的解决方案快20倍。这种卓越的性能使得Cerebras能够在处理复杂的AI任务时,显著减少响应时间,从而提升用户体验。

在成本效率方面,Cerebras推理的定价策略极具竞争力。其每百万个令牌的费用仅为10美分,而同类云服务的费用通常高达2.90美元,这使得Cerebras在价格性能比上达到了100倍的优势。这种高性价比不仅降低了企业的运营成本,还使得更多的开发者能够利用高性能的推理服务来构建和优化他们的AI应用。

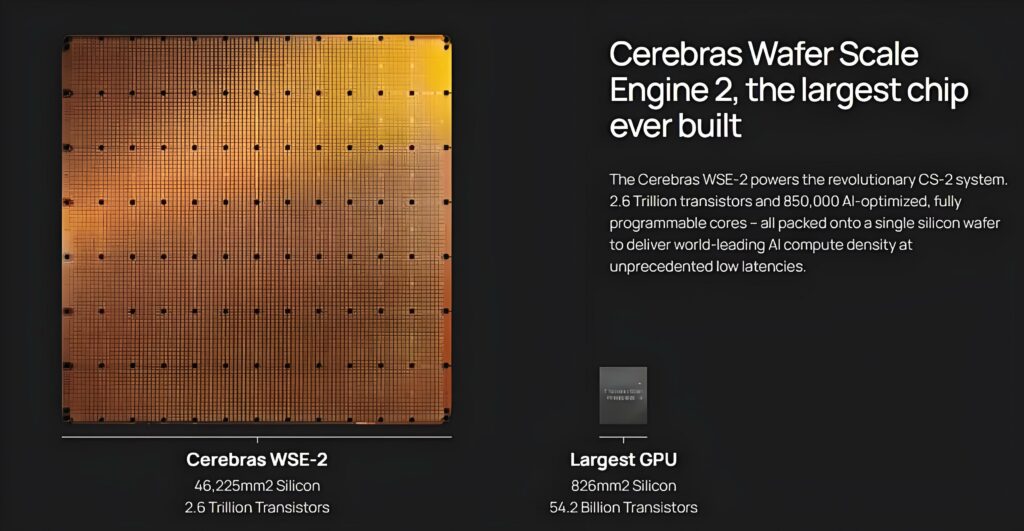

Cerebras推理的核心技术是其第三代晶圆级引擎(WSE-3),这是目前世界上最大的AI处理器。WSE-3的设计使其在内存带宽方面比NVIDIA H100高出7,000倍,这一特性解决了生成AI推理中的内存带宽瓶颈问题。WSE-3的巨大尺寸使得其能够在芯片上集成更多的内存,从而在处理大规模AI模型时,能够更快地读取和写入数据,极大地提高了推理的效率。

Cerebras推理技术的快速发展与半导体技术的进步密切相关,尤其是在新材料和集成技术的应用上。这种显著的性能提升主要得益于其独特的晶圆级引擎(WSE-3),该芯片的设计使其在内存带宽和处理速度上远超传统GPU。Cerebras的WSE-3芯片几乎占据了整个12英寸半导体晶圆的表面,提供了900倍于标准NVIDIA GPU的片上内存,和7000倍的内存带宽。通过将多个芯片紧密集成在一起,Cerebras能够在一个系统中实现更高的晶体管密度,从而提升整体计算能力。Cerebras的推理解决方案不仅在速度上领先,还在处理多步骤、实时性能的复杂任务时展现出更高的效率。这种能力使得开发者能够构建更为复杂的AI应用,例如实时语音响应和多轮交互的AI代理。

Cerebras推理还保持了16位精度的高准确性,确保在追求速度的同时不牺牲结果的质量。这种设计理念使得Cerebras能够在处理多轮查询和实时交互任务时,提供更为准确和可靠的结果。通过将推理任务的计算和数据流动优化到芯片内部,Cerebras不仅提升了处理速度,还为开发者提供了更为灵活和高效的AI应用开发环境。

Cerebras推理的应用场景

Cerebras推理技术在多个行业中的潜在应用正在引起广泛关注,尤其是在医疗、金融和技术等领域。其速度和效率的提升为AI驱动的解决方案提供了显著的增强。

在医疗行业,Cerebras推理可以加速疾病诊断和治疗方案的制定。通过快速处理大量医疗数据,Cerebras推理能够实时分析患者的病历、影像学数据和基因组信息,从而提供更准确的诊断和个性化的治疗建议。例如,Cerebras推理可以在几秒钟内处理数千个医学图像,帮助医生快速识别肿瘤或其他病变,这在传统的推理系统中可能需要数分钟甚至更长时间。

在金融领域,Cerebras推理的高效性使得实时风险评估和交易决策成为可能。金融机构可以利用其快速的数据处理能力,实时分析市场趋势和客户行为,从而做出更快速的投资决策。这种能力不仅提高了交易的效率,还降低了潜在的财务风险。例如,Cerebras推理可以在毫秒级别内处理数百万条交易数据,帮助交易员在瞬息万变的市场中把握机会。

在技术行业,随着AI模型的复杂性不断增加,传统的推理系统往往难以满足实时处理的需求。Cerebras推理通过其强大的计算能力,能够支持更复杂的AI应用,如自然语言处理和图像识别等。其高达1800个token每秒的处理速度,使得开发者能够构建更为复杂和互动的AI应用,提升用户体验。

此外,Cerebras推理的成本效益也为各行业带来了新的机遇。其每百万个token的费用仅为10美分,相比于传统云服务的价格,具有显著的竞争优势。这种高性价比使得更多企业能够负担得起高性能的AI推理服务,从而加速其数字化转型和创新进程。

Cerebras推理的商业模式

Cerebras推理的商业模式采用了按需付费的定价策略,这与传统的硬件销售模式形成了鲜明对比。这种按需付费的模式使得用户可以根据实际使用量进行支付,而不需要一次性投入大量资金购买硬件设备。在AI推理需求不断增长的背景下,对于许多企业而言这种定价策略是一个巨大的吸引力。

传统的AI市场通常依赖于硬件销售,企业需要购买昂贵的图形处理单元(GPU)和相关设备,需要高昂的前期投资,还会导致资源的闲置和浪费。相比之下,Cerebras的按需付费模式允许企业根据实际的推理需求进行灵活调整,降低了进入门槛和运营成本。

Cerebras的推理服务使用的WSE-3芯片的设计使得推理速度和内存带宽远超传统GPU,能够在更短的时间内处理更多的请求。这种高效的性能既能提升用户体验,还为开发者提供了更大的灵活性,能够支持更复杂的AI应用场景。Cerebras的CEO Andrew Feldman指出,快速的推理能力使得多轮交互和实时响应成为可能,这在传统的推理服务中是难以实现的。

Cerebras推理的市场影响

NVIDIA长期以来在AI推理市场中占据主导地位,其H100 GPU被广泛应用于各种AI应用中。然而,Cerebras推理服务使用的WSE-3芯片以其巨大的内存带宽和并行处理能力,显著提升了推理速度,解决了传统GPU在处理大规模AI模型时的瓶颈问题。

随着Cerebras的推理服务进入市场,NVIDIA及其他主要竞争对手面临着前所未有的压力。Cerebras不仅提供了更快的推理速度,还通过按需计费的模式降低了使用成本,这使得其服务对企业和开发者更具吸引力。例如,Cerebras的定价为每百万个token仅需10美分,而同类服务的费用则高达2.90美元,这一差异可能促使更多企业转向Cerebras的解决方案。

由于Cerebras的推理服务的高效的推理能力,开发者能够实现更复杂的多步骤任务和实时交互,这在传统推理服务中是难以实现的。例如,Cerebras的推理能力使得开发者能够创建更具人性化的AI体验,提升用户互动的质量和效率。

在市场竞争日益激烈的背景下,NVIDIA需要迅速调整其战略,以应对Cerebras带来的挑战。尽管NVIDIA的H100 GPU在性能上仍具备优势,但Cerebras的快速发展可能会迫使NVIDIA加快新产品的推出和技术的迭代,以保持其市场份额。同时,其他竞争者如AMD和Google也可能会受到Cerebras成功的启发,进一步加大在AI推理领域的投资和研发力度。

总的来说,Cerebras Inference的推出不仅为AI推理市场带来了新的竞争者,也可能重塑整个行业的格局。随着推理技术的不断进步和成本的降低,未来的AI应用将更加多样化和高效,推动整个行业向前发展。

留言

评论

暂时还没有一条评论.